开发语言

Shell脚本

嵌入式Linux SPI驱动

云笔记

人脸识别

拍照

flex

尚品汇

ecmascript

reactjs

File的创建功能

PM项目管理

hibernate

PromQL

颜宁

qemu

vuex

EmberZnet

pillow

华为全联接大会2022

triton

2024/4/12 20:42:30不使用 Docker 构建 Triton 服务器并在 Google Colab 平台上部署 HuggingFace 模型

Build Triton server without docker and deploy HuggingFace models on Google Colab platform EnvironmentBuilding Triton serverDeploying HuggingFace models客户端推荐阅读参考 Environment

根据Triton 环境对应表 ,Colab 环境缺少 tensorrt-8.6.1࿰…

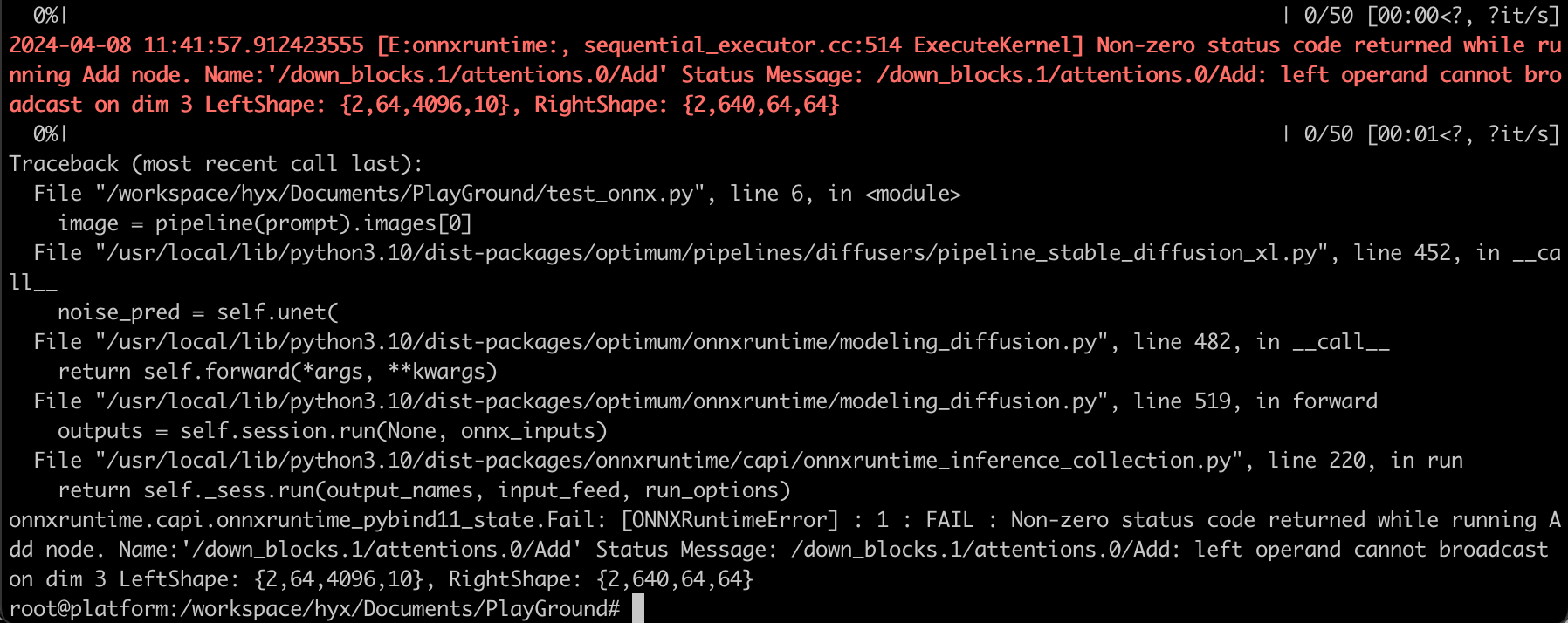

(含代码)利用NVIDIA Triton加速Stable Diffusion XL推理速度

在 NVIDIA AI 推理平台上使用 Stable Diffusion XL 生成令人惊叹的图像 扩散模型正在改变跨行业的创意工作流程。 这些模型通过去噪扩散技术迭代地将随机噪声塑造成人工智能生成的艺术,从而基于简单的文本或图像输入生成令人惊叹的图像。 这可以应用于许多企业用例&…

Triton Server Python 后端优化

接上文 不使用 Docker 构建 Triton 服务器并在 Google Colab 平台上部署 HuggingFace 模型

MultiGPU && Multi Instance

Config

追加

instance_group [{count: 4kind: KIND_GPUgpus: [ 0, 1 ]}

]Python Backend

Triton 会根据配置信息启动四个实例,…

stable diffusion model训练遇到的问题【No module named ‘triton‘】

一天早晨过来,发现昨天还能跑的diffusion代码,突然出现了【No module named ‘triton’】的问题,导致本就不富裕的显存和优化速度雪上加霜,因此好好探究了解决方案。

首先是原因,由于早晨过来发现【电脑重启】导致了【…

LLM推理框架Triton Inference Server学习笔记(一): Triton Inference Server整体架构初识

官方文档查阅: TritonInferenceServer文档

1. 写在前面

这篇文章开始进行大语言模型(Large Language Model, LLM)的学习笔记整理,这次想从Triton Inference Server框架开始,因为最近工作上用到了一些大模型部署方面的知识, 所以就快速补充了…

Triton教程 --- 自定义操作

Triton教程 — 自定义操作 Triton系列教程:

快速开始利用Triton部署你自己的模型Triton架构模型仓库存储代理模型设置优化动态批处理速率限制器模型管理

自定义操作

Triton 推理服务器部分支持允许自定义操作的建模框架。 自定义操作可以在构建时或启动时添加到 Triton&…

5.从头跑一个pipeline

1.安装torch

pip install torchvision torch

PyTorch的torchvision.models模块中自带的很多预定义模型。torchvision 是PyTorch的一个官方库,专门用于处理计算机视觉任务。在这个库中,可以找到许多常用的卷积神经网络模型,包括ResNet、VGG、…

分析解决【No module named ‘triton‘】的问题

(一)现象

在Windows11下训练Stable-Diffusion的LoRA模型的时候,总是重复提示: A matching Triton is not available, some optimizations will not be enabled. Error caught was: No module named ‘triton’ 意思是:…

碰到一个用pip死活装不上模块的问题(ModuleNotFoundError: No module named ‘triton‘)

折腾了半天才发现问题的根源在于平台不同。 当我在windows上尝试用pip install triton命令安装该模块的时候,总会提示

A matching Triton is not available, some optimizations will not be enabled.

Error caught was: No module named triton而一个模块如果只在…

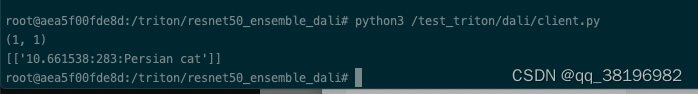

TensorRTTriton学习笔记(一):triton和模型部署+client

前言

先介绍TensorRT、Triton的关系和区别:

TensorRT:为inference(推理)为生,是NVIDIA研发的一款针对深度学习模型在GPU上的计算,显著提高GPU上的模型推理性能。即一种专门针对高性能推理的模型框架&…